III) Interprétation et utilisation des données fournies par une image satellitale

1°) L’image satellitale : un produit brut complexe et riche en renseignements

a. L’image elle-même

2°) Le monde de la photointerprétation

a. Autour des images : des entreprises, des métiers, des institutions

L'intérêt des images enregistrées par les satellites tient à plusieurs propriétés :

- elles recèlent une information fraîche et fiable, actualisée rapidement, et très riche puisque même la lumière invisible à l'œil nu peut intervenir,

- ces informations sont utilisables dans des domaines multiples et très spécialisées : on peut travailler, retransformer l’image sans perdre d’informations afin de pouvoir l’exploiter de la façon voulue,

- elles possèdent une certaine objectivité puisqu'elles résultent d'une mesure physique,

- elles sont universelles car elles peuvent concerner n'importe quel lieu de la Terre, même les plus reculés,

- elles se présentent sous forme numérique, le langage de l'informatique, et sont ainsi maniables et peuvent être transmises rapidement (contrairement à des photos argentiques),

- elles sont accessibles à tous via des sociétés ayant une large clientèle.

1°) L’image satellitale : un produit brut complexe et riche en renseignements

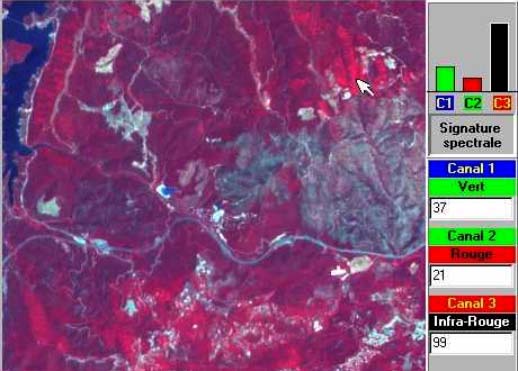

Une image satellitale n’est pas une photo (cf. I]), elle se différencie d’une photo par les capteurs satellitaires qui la produisent et qui ne sont pas des capteurs photographiques mais des capteurs radiométriques captant les ondes électromagnétiques provenant de la Terre et qu’émet tout objet (lumière). Par exemple SPOT est équipé de 2 caméras multispectrales, dites Haute Résolution Visible, sensibles dans 2 bandes du rayonnement visible (rouge et vert), et 1 autre dans la bande du proche infrarouge. Cela implique qu’à la réception des données envoyées par le satellite la société propriétaire reçoit une image dont les couleurs dépendent de la résolution spectrale des objets, et de plus transmises selon un système qui n’est pas celui des couleurs réelles mais bien une autre forme de codage, la transcription RVB (Rouge (pour le canal infrarouge) Vert (pour le canal rouge) Bleu (pour le canal vert)).Ces couleurs ne sont pas de vraies couleurs : on parle de pseudo couleurs naturelles ou alors de fausses vraies couleurs.

Grâce au canal infrarouge (codé en rouge) on analyse l’humidité des sols, l’importance de la végétation et de sa croissance.

Grâce au canal rouge (codé en vert) on analyse l’activité végétative (croissance des feuilles, des cultures dans les champs).

Grâce au canal vert (codé en bleu) on analyse les eaux littorales, les sols, les constructions, la différenciation entre différents types de végétaux.

A partir de là plusieurs gammes se dessinent dans chacune des 3 dominantes :

Du rouge vif au marron foncé : forêts, des feuillus aux conifères, toute végétation saine et dense : prairies, céréales en herbe, gazons ;

De marron à beige : végétation méditerranéenne (de la Pinède aux garrigues) ;

De jaunes, jaunes-vert à vert Kaki : ce sont les différents états de culture sèches (méditerranéennes ou tropicales sèches) ;

Des rouges violacés : cultures en pleine croissance ;

Rose à beige ou verdâtre : prairies plus ou moins sèches ;

Bleu outremer : peu de culture, sol à peine couvert mais humide ; Sols nus ou à végétaux peu couvrants

Différentes gammes de bleu (du bleu très foncé presque noir au bleu pâle) : eau turbide à différentes profondeurs : mer, lac, rivières (plus la profondeur est importante et plus la couleur est foncée) ;

Gris-bleu : les constructions diverses : routes, toits, aéroports ;

Blanc : neige, nuages, roche nue, sable, carrières, chantiers, béton frais.

Cette hiérarchisation est directement liée à la réflectance des objets, en effet au plus ceux ci reflètent la lumière et au plus la couleur qui leur sera attribuée en système RVB sera claire.

L’image dépend aussi d’un autre facteur : c’est sa résolution spatiale, c’est-à-dire sa précision et la surface prise en compte.

La résolution spatiale ou géométrique est la distance la plus petite permettant de discriminer deux objets voisins. Cette résolution s'exprime en mètres ou en kilomètres et mesure le coté d'un pixel. Par exemple une résolution grossière (en centaines de mètres ou en km) ne permettra pas de distinguer des objets spatiaux de « petite » taille (bâtiments, parcelles, …). Au contraire, une résolution plus fine (quelques dizaines de mètres à un mètre) permet d’observer de façon plus précise la zone en question et d’y discerner des réseaux, des structures, …

Une résolution de 20m correspond à une plus petite distance observable de 20m. Ainsi un pixel (la plus petite unité de la photo) sera un carré de 20m X 20m soit 400m². Cela peut paraître peu mais à l’échelle de notre planète et à la distance (830 km) ou les satellites effectuent leur travail c’est déjà un exploit technologique, et cette résolution est suffisante dans un certain nombre de cas (parcelles agricoles importantes,..) mais pas dans celui de notre étude ou pour étudier les conséquences d’un incendie dans une zone sinistrée et peu mesurable sans le recul propre à un satellite, il faut obtenir des images d’une grande résolution spatiale. Une résolution spatiale élevée autorise la distinction d'objets spatiaux de petite taille. Mais plus la résolution augmente, plus le poids de la donnée (exprimée en octets, voire en Mo) des images est important, ce qui ralentit les traitements, nécessite un matériel très performant et évidemment coûte beaucoup plus cher. De plus, l'augmentation de la résolution spatiale va de pair avec la diminution de la taille des scènes (portion de surface terrestre observée et enregistrée).

| Résolution mode panchromatique | Résolution mode multispectral | Taille de la scène |

|

|---|---|---|---|

| IKONOS | 1 mètre |

4 mètres |

10 x 10 km |

| SPOT | 10 mètres |

20 mètres |

60 x 60 km |

| LANDSAT | / |

30 mètres |

180 x 180 km |

| NOAA | / |

1,1 km |

2500 x 2500 km |

La course à la plus petite résolution possible n'a donc pas de sens. Le choix d'une résolution doit se faire en fonction d'une problématique de recherche précise. Il serait aussi absurde d'étudier la végétation de l'ensemble du continent africain à l'aide d'images Ikonos que d'étudier une zone ravagée par le feu à l'aide d'images NOAA. Il faut adapter les choix de ses images à sa problématique de recherche en non l'inverse.

Après son arrivée sur Terre, il faut transformer l’image afin que celle-ci puisse être étudiée :

A présent l’image est enregistrée et observable, mais pas exploitable : elle ne correspond à rien. Les couleurs ne sont pas celles que nous voyons et l’image n’a pas tout à fait l’allure d’une « carte photographique », quant à y distinguer un quelconque phénomène ayant perturbé une zone précise, c’est impossible puisque l’image ne donne que très peu de points de repères « terrestres ».

Image moyenne résolution NOAA qui donne une idée de ce que voit le satellite

L’image est donc sujette à plusieurs problèmes :

D’un point de vue radiométrique (captage de l’information) il faut corriger les données des effets atmosphériques (vent solaire,…) ainsi que les variations dues aux problèmes des capteurs (vieillissement/dérèglement, défaut de conception,…).

Puis d’un point de vue géométrique il faut intervenir sur les distorsions intervenues lors de l’enregistrement de la scène : celles causées par l’environnement (courbure de la Terre, variation d’altitude au sol), les mouvements de la plate-forme(roulis, tangage, lacet) et les erreurs dues aux systèmes de mesure.

Après ces corrections on peut enfin songer à replacer l’image dans un cadre géographique, la géoréférencer (positionner en latitude et en longitude la cible sur la surface terrestre, afin de pouvoir la projeter sur un fond de carte par exemple).

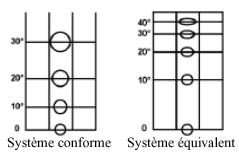

Il faut déjà passer de la forme « bombée » de la Terre à une projection plane, problème bien connu des différentes représentations :

Les coordonnées terrestres

La terre est une sphère, mais une sphère imparfaite :

- Le Géoïde est la forme théorique qui se rapproche le plus de la surface réelle de la terre c’est à dire

le niveau moyen des mers. Il sert de référence pour déterminer les altitudes.

- L’ellipsoïde est la surface mathématique qui se rapproche le plus de la forme du géoïde ; grâce à ce

dernier, on peut calculer les coordonnées géographiques en LONGITUDE et en LATITUDE.

- Le procédé mathématique qui permet le passage de l’ellipsoïde au plan se nomme : système de représentation plane ou système de projection ou projection. Cette transformation ne va pas sans déformation (linéaire, surfacique, angulaire)

Classement des projections d’après les altérations

- La déformation linéaire : aucune projection ne conserve sur la carte toutes les longueurs.

- La déformation angulaire : les projections conformes conservent les angles au détriment des surfaces. Elles sont utilisées pour des données à grande échelle de type topographiques.

- La déformation surfacique : les projections équivalentes conservent les surfaces mais pas les angles. Elles sont utilisées pour le cadastre et pour des données à petite échelle.

Les projections dites aphylactiques ne conservent ni les angles ni les surfaces mais sont un compromis compensant au mieux les altérations, utilisées pour les représentations de type planisphère.

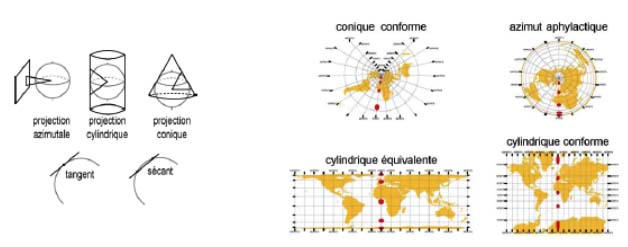

Classement des systèmes d’après la surface de projection : projection azimutale, conique, cylindrique.

Elle peut être tangente ou sécante, directe, transverse ou oblique.

La projection légale en France est la projection Lambert 93. Elle a été définie pour le nouveau système géodésique RGF93 (Réseau Géodésique Français 1993)qui est une densification du réseau européen.

L’organisme distributeur des images de SPOT effectue différents niveaux de traitement vis-à-vis de ses images :

| Niveau de correction | Corrections radiométriques | Corrections géométriques | Précision de l’image |

|---|---|---|---|

| 1A | Egalisation des détecteurs | Aucunes | Faible |

| 1B | Sans repères terrestres | 500 m | |

| 2A | Comme 1B mais géoréférencées | / | |

| 2B | Comme 2A avec points d’amer | 30 m |

Que signifient ces différents termes ?

Niveau 1A

Niveau 1A

L'image Spot est de forme carrée. Les données auxiliaires (coordonnées du centre de la scène et des quatre coins) permettent de localiser l’image au sol avec une précision supérieure à 500 m .

Les images sont orientées parallèlement à l'orbite du satellite. Aucune correction géométrique n'est appliquée. L'image est fournie telle qu'elle est acquise, avec sa géométrie brute. Il s'agit d'une grille de pixels.

Niveau 1B

Niveau 1B

Les données sont ré-échantillonnées et des corrections géométriques sont réalisées afin de compenser les effets systématiques : rotation et courbure de la Terre, déformations induites par les angles de prise de vue, etc.

La scène SPOT se présente sous la forme d’un parallélogramme.

Les données auxiliaires (coordonnées du centre de la scène et des quatre coins, modèle de localisation) permettent de localiser l’image au sol avec une précision supérieure à 500 m.

Niveau 2B

Niveau 2B

Les corrections géométriques se basent en plus sur des données géographiques ou cartographiques.

Ces informations supplémentaires sont constituées par des points d’appui dont les coordonnées cartographiques ou géographiques sont mesurées sur une carte ou au sol (points GPS). Ceci entraîne une amélioration importante de la précision de la localisation de tout point dans l'image, précision qui peut aller de 10 à 30 m, suivant la qualité des cartes (pour autant que le terrain soit plat).

La scène Spot a la forme d’un parallélogramme ayant subi la rotation nécessaire pour correspondre au système de coordonnées cartographiques (l’image est souvent orientée vers le nord).

Niveau ORTHO

Ce degré de pré-traitement très élaboré répond aux besoins d’une précision cartographique maximale : il corrige les erreurs résiduelles de parallaxe dues au relief grâce à l’utilisation d’un MNT (modèle numérique de terrain).

A ces manipulations s’ajoutent encore d’autres contraintes dès que l’on veut obtenir des documents venant de plusieurs sources différentes. En effet dans ce cas il faut pouvoir raccorder les images, ce qui signifie qu’il faut avoir la même échelle et de préférence la même résolution (afin d’éviter d’obtenir d’un côté de l’image un carré d’une couleur peu représentative face à l’autre côté où on va distinguer des nuances de couleur (cultures,…). C’est un travail long et minutieux qui nécessite de l’attention afin que le « lecteur » ne distingue pas les raccords, ce qui est d’autant plus difficile si les captures des images sont éloignées dans le temps : en effet les instruments du satellite sont influencés par les circonstances du moment où l’image est relevée : luminosité, vent solaire, conditions atmosphériques, même si le travail des techniciens est de veiller à ce que cette influence soit minime, elle n’en reste pas moins présente. Il est donc très difficile de faire coïncider des images de façon régulière et lissée.

A partir de là, on obtient enfin une image digne d’une photo aérienne avec une résolution ou une surface bien supérieure. On peut considérer cette image comme le stade évolué d’une orthophoto (Orthophotoplans : photographies aériennes dont les déformations (dues à la prise de vue et au relief du terrain) ont été corrigées de manière à ce que la photo corresponde à un système de projection cartographique donné). Bien qu’elle puisse parfois avoir des problèmes malgré tous les traitements dont elle fait l’attention. Néanmoins et après un dur labeur (ce qui se voit dans le prix de ces images), les techniciens peuvent présenter des « photos prises de haut » qui sont de véritables œuvres d’art contemporaines.

La télédétection (La télédétection est l‘ensemble des connaissances et techniques utilisées pour déterminer des caractéristiques physiques et biologiques d'objets par des mesures effectuées à distance, sans contact matériel avec ceux-ci) permet de changer complètement de perspective, elle offre une vision nouvelle de l’espace en englobant de très grands ensembles. Elle est très intéressante pour étudier des processus qui ont une large diffusion spatiale. On peut interpréter les images par des moyens multiples :

La photointerprétation (Photointerprétation : travail consistant à représenter sous forme de cartes des éléments repérés sur des orthophotoplans) est un métier, qui demande une formation et des connaissances importantes pour savoir interpréter, être critique envers une image et savoir en tirer les informations importantes.

On peut aussi interpréter les images numériquement (PIAO = PhotoInterprétation Assistée par Ordinateur), grâce aux filtres de texture et aux rapports de canaux on peut mettre en avant certains paramètres et ainsi exploiter l’image selon une dynamique précise.

Elle est susceptible de subir de nombreux traitements mathématiques pour faire apparaître ce qui intéresse l’utilisateur (relief, nature du sol, végétation, infrastructures humaines, …)

Il est possible de programmer son acquisition à une date précise et ainsi de pouvoir suivre l’évolution de phénomènes particuliers (croissance urbaine, désertification, conséquences d’un incendie,…)

Ces images peuvent servir de fonds de carte précis sur lesquelles il sera possible de faire figurer d’autres données en langage hypertexte (Systèmes d’Informations Géographiques).Les SIG sont des cartes améliorées : elles renferment des données géographiques et des données administratives, d’équipement,..

Dans notre cas on peut par exemple penser à une opération visant à mettre en avant l’indice de végétation NDVI (Normalized Difference Vegetation Index) qui permet d’identifier les groupements notamment en soulignant la biomasse. NDVI = (PIR-R)/(PIR+R) où PIR représente la réflectance dans le canal proche Infrarouge et R dans le canal Rouge. Un indice faible correspond à des sols nus, l’indice augmentant avec l’importance de la végétation.

Les logiciels TITUS et GEOIMAGE permettent de calculer ces indices et de tracer l’évolution d’une région (reprise de la végétation après un incendie, différences entre les espèces,…).

Ces images sont des produits : elles sont le fruit d’un travail et répondent à un besoin. Tout autour d’elles s’organise une dynamique des offres, des besoins, des professionnels de cette technique d’imagerie et des clients.

2°) Le monde de la photointerprétation

a. Autour des images : des entreprises, des métiers, des institutions

L’image que l’on utilise pour analyser un phénomène tel que des incendies forestiers ou même pour décorer est un produit fini : sa création a aussi au-delà d’un aspect scientifique un but commercial, puisque des entreprises privées telles que SPOTImage (France + Belgique et Suède) ou NOA (Etats-Unis) vivent de leur vente (5 millions d’images revendues sur Internet en 10 ans) afin de répondre à une demande émanant de professionnels (géologues, etc..), du monde de l’éducation et aussi du grand public. Cependant ce support reste particulier puisque son exploitation est difficile, demandant de l’expérience et une formation spéciale : par exemple le rendement d’un photogéologue est de 250 photos par mois, mais ces photos sont des donnés précieuses que le spécialiste peut et se doit d’étudier mm² par mm²

Des laboratoires et des institutions travaillent en permanence sur ce support afin d’obtenir des données toujours plus précises et plus fiables. Les images satellitales, nouveau moyen de représenter le monde, sont au cœur d’initiatives multiples et sont un produit aujourd’hui particulièrement apprécié des coopératives agricoles,…

Parmi les différents laboratoires en relation avec la télédétection et l’imagerie satellitale, on peut citer le LCT (Laboratoire Commun de Télédétection) situé à Montpellier, commun à l’ENGREF (Ecole Nationale du Génie Rural des Eaux et des Forêts), au CEMAGREF (Institut de recherche pour l'ingénierie de l'agriculture et de l'environnement), au CIRAD (Centre de coopération internationale en recherche agronomique pour le développement), et à l’IRD (Institut de recherche pour le Développement).

Le CARTEL (Centre d'applications et de recherches en télédétection), créé en 1985, est un des plus importants centres de recherche universitaire au Canada, oeuvrant dans le domaine de la télédétection.

Dans une optique encore plus globale et à une échelle internationale on peut aujourd’hui parler d’une véritable volonté d’accéder toujours plus vite et de façon plus fiable aux informations que procurent les satellites avec la création en juillet 1999 de la charte internationale : « Espace et catastrophes majeures », à la suite de la conférence UNISPACE III, qui a eu lieu à Vienne, par l'Agence spatiale européenne (ESA) et le Centre national d'études spatiales (CNES). L'Agence spatiale canadienne a aussi ratifié cette charte le 20 octobre 2000. En septembre 2001, la National Oceanic and Atmospheric Administration (NOAA) et le Indian Space Research Organization (ISRO) sont aussi devenus membres de la Charte. L'agence spatiale de l'Argentine (CONAE) est devenue membre en juillet 2003.

La Charte internationale offre un système unifié d'acquisition et de livraison des données satellites dans les cas de catastrophes d'origine naturelle ou humaine. Chaque agence participant de la charte s'est engagée à fournir des ressources à l'appui de la Charte et contribue ainsi à atténuer les répercussions de telles catastrophes sur la vie des gens et la propriété.

La Charte internationale est officiellement entrée en vigueur le 1er novembre 2000. Un utilisateur autorisé peut ainsi composer un seul numéro de téléphone pour demander la mobilisation des ressources spatiales et des ressources terriennes connexes (RADARSAT, ERS, SPOT) des trois agences, de manière à obtenir des données et de l'information sur une catastrophe.

Jour et nuit un opérateur répond à l'appel, vérifie l'identité du demandeur ainsi que le contenu de la fiche envoyée par l'utilisateur autorisé. L'opérateur transmet ensuite cette information à l'ingénieur d'astreinte qui, après analyse de la demande et du type de désastre, prépare un plan d'acquisition et de choix d'archives en utilisant les ressources spatiales disponibles. L'acquisition et la livraison des données sont faites en tenant compte de l'urgence de la situation, et un chef de projet, qui possède les compétences requises en commande, traitement et application des données, seconde l'utilisateur pendant tout le processus.

Ainsi à tout moment et dans n’importe quelles conditions, une agence membre peut demander à obtenir des images de façon rapide et précise. Cette cohésion internationale sort du pur cadre commercial pour mettre la technologie au service de la science mais surtout de l’humanitaire.

La charte a couvert plusieurs incendies depuis sa création :

Au Canada en août 2003

En Bolivie le 16 septembre 2004

Dans le Var en juillet 2003,etc…

Le tableau suivant donne une idée dans différents domaines de ce que l’imagerie satellitale permet de faire.

| Domaines | Applications |

|---|---|

| Géosciences | Géologie, pédologie, géomorphologie, volcanologie |

| Milieu marin et littoral | Qualité de l’eau, circulation océanique, végétation marine |

| Atmosphère et climat | Météorologie, bilans énergétiques et hydriques |

| Hydrologie | Comportements de l’eau à la surface du sol et dans le sol, cycles de l’eau |

| Glaciologie | Suivi des glaciers |

| Biosphère | Cartographie de la végétation |

| Espace aménagé | Statistiques agricoles, foresterie, croissance des villes |

| Archéologie | Cartographie de sites archéologiques |

| Humanitaire | Pré-alerte de famines ; réfugiés (camps) |

| Santé | Prévision des épidémies, relations avec changements globaux |

| Catastrophes environnementales | Feux de forêts, inondations, sécheresses, marées noires, etc. |

| Changements globaux | Désertification, variations climatiques, composition de l’atmosphère |

Bien sûr, ces différentes applications ne se déroulent pas à la même échelle

La télédétection était à la base une technique uniquement militaire et comme toute technologie elle est entrée dans le civil avec le temps. De plus, les photos prises par satellites sont d’abord évidemment réservées à un usage militaire, car la connaissance du terrain est un facteur de réussite important des opérations dans le domaine de la Défense : les satellites à usage militaire sont de 2 à 10 fois plus précis que les satellites civils (résolution 10 fois plus importante).Ces satellites que nous ne connaissons donc pas permettent :

- Des analyses et une cartographie de terrain

- Une visualisation de sites

- Du renseignement militaire

- La planification logistique

- Des négociations politiques

- L'organisation et la préparation des missions

- La simulation de vols

- Des états des lieux

- La suppression des risques

- les missions humanitaires.

On voit donc que les applications de l’imagerie satellitale en dehors du cadre des feux de forêts sont multiples

- 1858 : première photo aérienne depuis un ballon par Nadar

- 1861 : technique de photographie couleur par Maxwell

- vers 1870 : premières images haute altitude (10’000m) depuis ballons

- 1887 : utilisation de la photographie pour la foresterie (Allemagne)

- 1906 : première photo depuis une fusée (800m d’altitude)

- 1909 : première photo depuis un avion par Wilbur Wright

- 1914-18 : développement de la photographie aérienne

- 1919 : détection infrarouge depuis un avion

- 1936 : première photo de la courbure terrestre (22’000m, ballon)

- 1939-45 : développement des techniques de photo-interprétation

- 1942 : film couleur infrarouge par Kodak

- 1946 : premières photo de l’espace par des fusées V-2

- 1954 : système radar aéroporté (Westinghouse)

- 1960 : lancement de TIROS 1 première image satellitaire

- années 1960 : photos satellites d’espionnage (Corona, KH)

- fin années 1960 : photos depuis Apollo et Gemini

- 1972 : lancement du Earth Resources Technology Satellite (ERTS), rebaptisé plus tard Landsat 1 ; photos de Skylab

- 1975 : Landsat 2

- 1978 : Landsat 3 ; Seasat, premier satellite radar civil ; NOAA 6 (ex TIROS) avec le Advanced Very High Resolution Radiometer (AVHRR) à 1km de résolution spatiale

- 1982 : Landsat 4 (avec le capteur Thematic Mapper)

- 1984 : Landsat 5

- 1985 : RESURS-01 #1 (Russie)

- 1986 : SPOT-1 (France)

- 1988 : Indian Remote Sensing Satellite (IRS), RESURS-01 #2

- 1989 : Meteosat

- 1990 : SPOT-2

- 1991 : European Radar Satellite (ERS-1) ; IRS-2

- 1992 : Japanese Earth Resources Satellite (JERS)

- 1993 : SPOT-3

- 1994 : Echec de la mise sur orbite de Landsat-6, RESURS-01 #3

- 1995 : IRS-3 ; ERS-2 ; RADARSAT ; images secrètes de CORONA et KH (années 60) accessibles au public

- 1997 : SeaWiFs

- 1998 : SPOT-4, RESURS-01 #4

- 1999 : Landsat-7, Ikonos (1 mètre de résolution)

- 2000 : Terra-MODIS, navette spatiale Endeavour (topographie), QuickBird

- 2002 : SPOT-5, ENVISAT

Grâce à ces différentes techniques on a pu lancer des projets visant à cartographier le sol de façon numérique afin de pouvoir créer une carte du monde en 3D et d’exploiter ces données à des fins multiples.

Par exemple le programme CORINE Land Cover :

Le programme européen CORINE Land Cover a pour objet de fournir, pour les pays de l'Union Européenne, une information géographique homogène sur l'occupation du sol. En France, il a pour maître d'ouvrage l'Institut Français de l'Environnement (IFEN). Il bénéficie de la participation financière de la Commission européenne (DG XI et XVI), du Centre National d'Etudes Spatiales (CNES) et du Ministère de l'Aménagement du Territoire et de l'Environnement.

Les principaux partenaires techniques du programme français sont le Bureau de Recherches Géologiques et Minières (BRGM), l'Inventaire Forestier National (IFN) et l'Institut Géographique National (IGN). Certains organismes et entreprises ont contribué au programme français : IGN-France International, SIRS, Metalog, Unisfère, IETI Consultants, Scot Conseil, Planistat Europe, le laboratoire Costel, l'IAURIF et le Conseil Régional du Nord-Pas-de-Calais. La continuité du programme CORINE Land Cover et la diffusion des résultats sont assurées par l'Agence Européenne pour l'Environnement.

Cet inventaire biophysique de l'occupation du sol par télédétection s'intéresse à la biodiversité sur l'ensemble du territoire et permet d'intégrer plus efficacement la connaissance de l'environnement à l'ensemble de l'aménagement du territoire. La couverture complète du territoire national métropolitain se termine en 1996.

La gestion sur ordinateur des cartes thématiques réalisées à partir des images satellites représente l'un des aboutissements du programme CORINE Land Cover. Les applications pour la surveillance du patrimoine naturel sont nombreuses:

• Identification des évolutions de l’occupation du sol grâce à la superposition des cartes CORINE avec des scènes satellites prises à des dates différentes;

• Analyse de la diversité écologique du territoire, par le croisement avec d'autres cartes thématiques (zones naturelles, zones protégées, inventaires forestiers, aires de répartition des espèces);

• Simulation des impacts globaux des grands aménagements, grâce aux découpages possibles des cartes CORINE en fonction des limites de bassins versants, des limites administratives ou des zones d'étude.

3°) L’interprétation d’images satellitales dans le cadre d’un incendie de forêt, l’exploitation et la construction d’une dynamique

Pour ce faire on suivra les étapes du TP décrit sur le site educnet.fr (observation de la Terre puis applications pédagogiques).

Un incendie de forêt a ravagé fin août 1990 une partie du massif des Maures (Var - France), brûlant environ 10000 ha de forêts et de garrigues. Comment le milieu réagit-il à cette perturbation et comment pouvons-nous le voir ?

Pour placer le contexte, on va décrire le milieu brûlé et son évolution. Appelons an0 le moment de l’incendie (équivalent à t0) puis an1, an2 la période d’observation de chaque année successive à la même date que celle de l’incendie, c’est-à-dire fin juin – début juillet.

Considérons l’évolution des strates au cours du temps sur un pixel moyen de la zone brûlée.

Juste avant l’incendie (figure 1), la zone est couverte de hautes futaies de châtaigniers, pins, chênes verts et chênes-lièges. Avec une imagerie SPOT Avec les pixels de 20X20 m = 400 m_ chacun paraissent homogènes, la couleur semble être la même ce qui indique qu’on se trouve dans une zone ou les essences forestières et la densité ne changent pas. On définit ce stade et cet état du pixel par une proportion d’arborés A = 100%.

Figure 1 : Etat du milieu avant le feu

Figure 1 : Etat du milieu avant le feu

A l’an 0 (quelques jours après l’incendie, figure 2), la quasi-totalité de la végétation a été brûlée. Seuls quelques arbres isolés (chênes-lièges en particulier) ont subsisté, leur houppier (branches situées au-dessus du fût) ayant été fortement réduit par l’incendie. On définit la partie arborée résiduelle A # 5%, le reste étant pris par le sol nu, noirci par le feu. On dira que SN # 95%.

Figure 2 : Etat du milieu quelques jours après l’incendie

Figure 2 : Etat du milieu quelques jours après l’incendie

A l’an 1 (figure 3), le sol s’est nettoyé donc éclairci, les herbes ont poussé au détriment du sol nu : le taux d’herbacés H croît de façon inversement proportionnelle au taux de sol nu SN qui décroît. Le taux d’arborés reste sensiblement à la même valeur A # 5%. D’ailleurs, au cours des 6 années de suivi, leur évolution est si lente que nous avons considéré A constant.

Figure 3 : Etat du milieu au bout d’un an

Figure 3 : Etat du milieu au bout d’un an

A l’an 2, les arbustifs commencent à prendre de l’importance et vont supplanter peu à peu les herbacées. Le taux de sol nu continue à décroître : la vie reprend ses droits ! A ce stade, nous observons plus nettement des effets de compétition entre strates végétales. Chaque strate cherche à occuper l’espace disponible avec une vitesse de colonisation propre. Globalement on peut dire que les herbacés ont une vitesse forte (T = 1 an environ), les arbustifs démarrent plus lentement (T= 2 à 4 ans) mais entrent en concurrence avec les herbacés qu’ils remplacent progressivement à partir de l’an2.

Plus tard, à l’an 6 par exemple (figure 4), le taux A est à peine plus grand que 5%. Le taux de sol nu est tombé entre 10 et 30%. Les herbacés sont revenus à une valeur assez faible H # 20%, au détriment des arbustifs Ab qui occupent plus de la moitié de l’espace.

Figure 4 : Etat du milieu à l’an 6

Figure 4 : Etat du milieu à l’an 6

Au cours des 6 ans de l’étude, les courbes-types d'évolution des pourcentages de quatre strates d’intérêt sont telles que représentées figure 5, à savoir :

o arborés : taux quasiment constant,

o sols nus : décroissance régulière,

o herbacés : croissance d’abord puis décroissance avec un maximum 2 ans environ après le feu,

o arbustifs : croissance régulière.

Au-delà de l’an 6, les arborés démarreraient : les résineux d’abord, remplaçant les arbustifs à partir d’une dizaine d’années puis les feuillus prenant le dessus après 30 à 50 ans.

Le pixel se compose donc en toute date et en tout point d’observation de la zone comme un mélange de 4 strates : arborés, herbacés, arbustifs et sols nus.

Ceci conduit à une disposition peu classique en télédétection puisque nulle part dans la zone brûlée, il n’existe de pixels purs par rapport aux thèmes recherchés : ni totalement arborés, ni totalement herbacés. Idem pour les arbustifs ou les sols nus. En tout pixel on a un mélange que l’on veut caractériser.

Par conséquent il faudra mettre en œuvre des techniques particulières qui nous permettent d’estimer les pourcentages de ces strates et leur évolution dans le temps et dans l’espace.

On part de l’image prise par SPOT (Système d’Observation Probatoire de la Terre) en codage RVB (cf. 1°), ici observée grâce au logiciel TITUS :

La végétation active, émettant beaucoup d’infrarouge, est repérée sur cette image en Rouge.

Le vert correspond à la zone brûlée fin août 1990

La végétation active, émettant beaucoup d’infrarouge, est repérée sur cette image en Rouge.

Le vert correspond à la zone brûlée fin août 1990

Grâce au logiciel TITUS on repère par seuillage des valeurs radiométriques dans le canal XS3, nombre de pixels correspondant à la surface brûlée. Cela permet d’avoir une base de travail et de se rendre compte des dégâts.

Puis le suivi et l’évaluation des dégâts vont se faire de façon de moins en moins régulière. On va d’abord prendre un certain nombre d’images pour voir comment la région réagit à la catastrophe.

(On travaille ici avec des images masquées pour mettre en évidence certains points)

On distingue à présent des sous zones brûlées.

Les variations ne sont pas aléatoires mais se retrouvent par secteurs différenciés. Au sol, il est difficile, 5 jours après l’incendie, de voir des différences entre zones, alors que le satellite le permet.

La capacité de l’image satellitale à nuancer de façon très précise selon la volonté des utilisateurs les données qu’elle présente est un avantage considérable pour travailler et exploiter les données.

On distingue à présent des sous zones brûlées.

Les variations ne sont pas aléatoires mais se retrouvent par secteurs différenciés. Au sol, il est difficile, 5 jours après l’incendie, de voir des différences entre zones, alors que le satellite le permet.

La capacité de l’image satellitale à nuancer de façon très précise selon la volonté des utilisateurs les données qu’elle présente est un avantage considérable pour travailler et exploiter les données.

Ceci conduit à une disposition peu classique en télédétection puisque nulle part dans la zone

Puis on va suivre l’évolution de la zone d’année en année afin de se rendre compte de la reprise végétale.

Une première approche de cette dynamique temporelle peut se faire par affichage successif des compositions colorées des images masquées de l’an0 année du feu à l’an 6.

Les dates d’acquisition des images sont entre le 15.06 et le 13.07 suivant les années ce qui permet de ne pas avoir de différences au niveau du cycle des plantes.

Ce qui permet de se rendre compte de la reprise végétale en différenciant les types de croissance.

On peut aussi faire intervenir le NDVI. L’utilisation d’indices de végétation, “ néo-canaux ” sensibles à la vigueur de la végétation chlorophyllienne permet de mettre en évidence la vitesse différentielle de reprise. Pour cela on attribue au NDVI de chaque année (ici an1 an3 et an5) une couleur précise dans l’image qui va permettre de les comparer.

Pour le NDVI de l’an1 on utilisera le bleu, pour le NDVI de l’an3 on optera pour la couleur verte et pour le NDVI de l’an5 on se servira du rouge.

Les zones de l’image à dominante rouge sont celles où la végétation s’est développée tardivement la dernière année. Les zones vertes ont une reprise forte, ayant démarré après la 2ème année. Les zones de l’image à dominante bleue sont celles qui ont eu une reprise végétale rapide la 1ère année mais peu dense. Les zones les plus feuillues sont signalées en blanc, elles correspondent à un fort indice de végétation maintenu pendant 3 ans

Les zones de l’image à dominante rouge sont celles où la végétation s’est développée tardivement la dernière année. Les zones vertes ont une reprise forte, ayant démarré après la 2ème année. Les zones de l’image à dominante bleue sont celles qui ont eu une reprise végétale rapide la 1ère année mais peu dense. Les zones les plus feuillues sont signalées en blanc, elles correspondent à un fort indice de végétation maintenu pendant 3 ans

Autre cas : L’incendie de la forêt du Tanneron en 1986

Sur l'image obtenue par le satellite Spot le 24 juillet. La végétation apparaît en rouge avec une signature spectrale caractéristique (beaucoup d'infrarouges proches sont renvoyés, le rouge est fortement atténué, donnant une valeur plus basse que ce qui est mesuré dans le canal vert). Les pentes dénudées donnent une teinte grisâtre en fausses couleurs. Le bitume de l'autoroute renvoie à peu près de la même manière les radiations des trois canaux de mesure. Il apparaît en gris .Les lacs absorbent beaucoup les infrarouges, ils apparaissent avec des teintes d'un bleu d'autant plus sombre que leur profondeur est importante.

Sur l'image obtenue par le satellite Spot le 24 juillet. La végétation apparaît en rouge avec une signature spectrale caractéristique (beaucoup d'infrarouges proches sont renvoyés, le rouge est fortement atténué, donnant une valeur plus basse que ce qui est mesuré dans le canal vert). Les pentes dénudées donnent une teinte grisâtre en fausses couleurs. Le bitume de l'autoroute renvoie à peu près de la même manière les radiations des trois canaux de mesure. Il apparaît en gris .Les lacs absorbent beaucoup les infrarouges, ils apparaissent avec des teintes d'un bleu d'autant plus sombre que leur profondeur est importante.

Le 29 juillet, on observe facilement la surface incendiée qui apparaît avec une couleur sombre. Les radiations infrarouges y sont maintenant fortement absorbées.

Ainsi grâce à la photointerprétation et aux différents traitements numériques on peut quantifier les dégâts causés sur la flore et évaluer la façon dont la nature réagit et reprend ses droits de façon globale, ce qui est impossible sans le recul que permet un satellite. En effet la force des images satellitales est d’être objectives tout en étant précises et exploitables de multiples façons.

Les images satellitales nous permettent de voir notre planète de plus loin et d’apprendre à mieux la connaître en présentant un regard nouveau sur des phénomènes à échelle importante.

L’emploi d’images satellitales dans un cadre de lutte contre les incendies de forêts, fléau de ce monde à l’heure où on parle de plus en plus de la réduction de la biomasse, est une technique qui peut être analytique et très riche d’enseignements mais aussi préventive, grâce aux données stockées et archivées des précédentes catastrophes on peut espérer pouvoir un jour prévenir de façon efficace les incendies et stabiliser les zones à risques